0x00 案例实现

创建的项目名称为BookManager,创建应用名称为Book,完成图书信息的维护

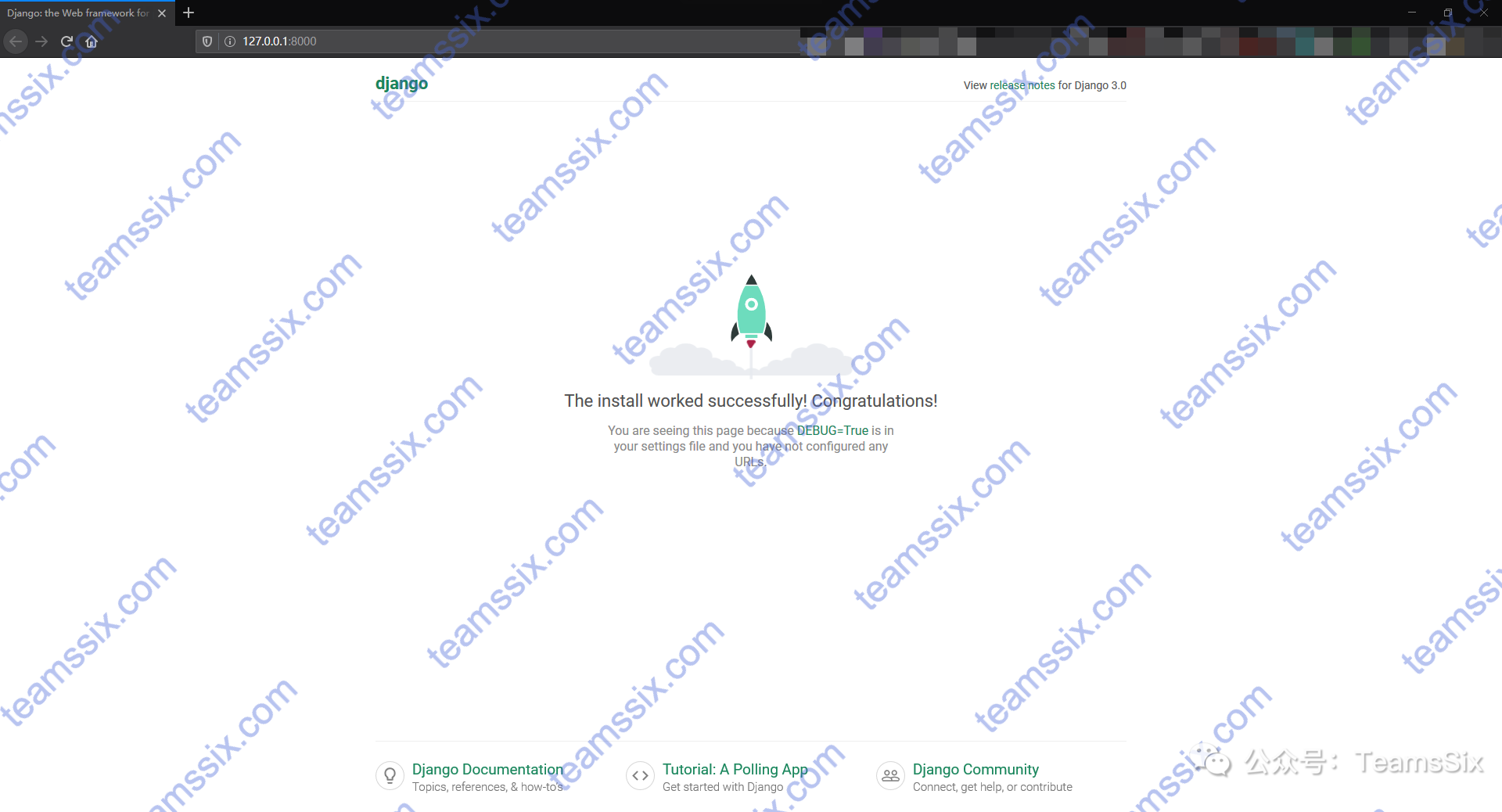

访问图书信息列表127.0.0.1:8000/booklist,并且点击每个图书能够跳转到对应图书人物信息界面

0x01 代码实现

2020-03-04

【Django 学习笔记】5、常用功能

【Django 学习笔记】5、常用功能

【Django 学习笔记】4、模板

【Django 学习笔记】4、模板

【Django 学习笔记】3、视图

【Django 学习笔记】3、视图

【Django 学习笔记】2、模型

【Django 学习笔记】2、模型

【Django 学习笔记】1、基础概念和MVT架构

【Django 学习笔记】1、基础概念和MVT架构

【Python Scrapy 爬虫框架】 6、继续爬虫、终止和重启任务

【Python Scrapy 爬虫框架】 6、继续爬虫、终止和重启任务

【Python Scrapy 爬虫框架】 5、利用 pipelines 和 settings 将爬取数据存储到 MongoDB

【Python Scrapy 爬虫框架】 5、利用 pipelines 和 settings 将爬取数据存储到 MongoDB

【Python Scrapy 爬虫框架】 4、数据项介绍和导出文件

【Python Scrapy 爬虫框架】 4、数据项介绍和导出文件

【Python Scrapy 爬虫框架】 3、利用 Scrapy 爬取博客文章详细信息

【Python Scrapy 爬虫框架】 3、利用 Scrapy 爬取博客文章详细信息

【Python Scrapy 爬虫框架】 2、利用 Scrapy 爬取我的博客文章标题链接

【Python Scrapy 爬虫框架】 2、利用 Scrapy 爬取我的博客文章标题链接

【Python Scrapy 爬虫框架】 1、简介与安装

【Python Scrapy 爬虫框架】 1、简介与安装

【Python 学习笔记】 异步IO (asyncio) 协程

【Python 学习笔记】 异步IO (asyncio) 协程

【Python 学习笔记】多进程爬虫

【Python 学习笔记】多进程爬虫

【Python Threading 学习笔记】6、锁lock

【Python Threading 学习笔记】6、锁lock

【Python Threading 学习笔记】5、不一定有效率GIL

【Python Threading 学习笔记】5、不一定有效率GIL

【Python Threading 学习笔记】4、Queue功能

【Python Threading 学习笔记】4、Queue功能

【Python Threading 学习笔记】3、join功能

【Python Threading 学习笔记】3、join功能

【Python Threading 学习笔记】2、添加线程

【Python Threading 学习笔记】2、添加线程