后台管理页面搞定之后,就需要做公共页面的访问了

对于Django的设计框架MVT:

用户在URL中请求的是视图

视图接受请求后进行处理

然后将处理的结果返回给请求者

使用视图时要进行的两步操作:

定义视图

配置URL

2020-03-01

【Django 学习笔记】3、视图

【Django 学习笔记】3、视图

【Django 学习笔记】2、模型

【Django 学习笔记】2、模型

【Django 学习笔记】1、基础概念和MVT架构

【Django 学习笔记】1、基础概念和MVT架构

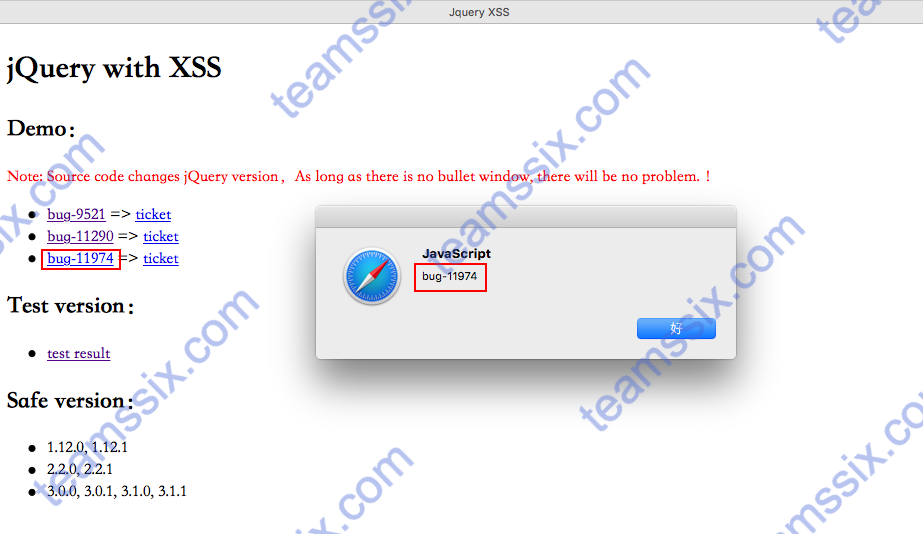

【工具分享】分享一个jQuery多版本XSS漏洞检测工具

【工具分享】分享一个jQuery多版本XSS漏洞检测工具

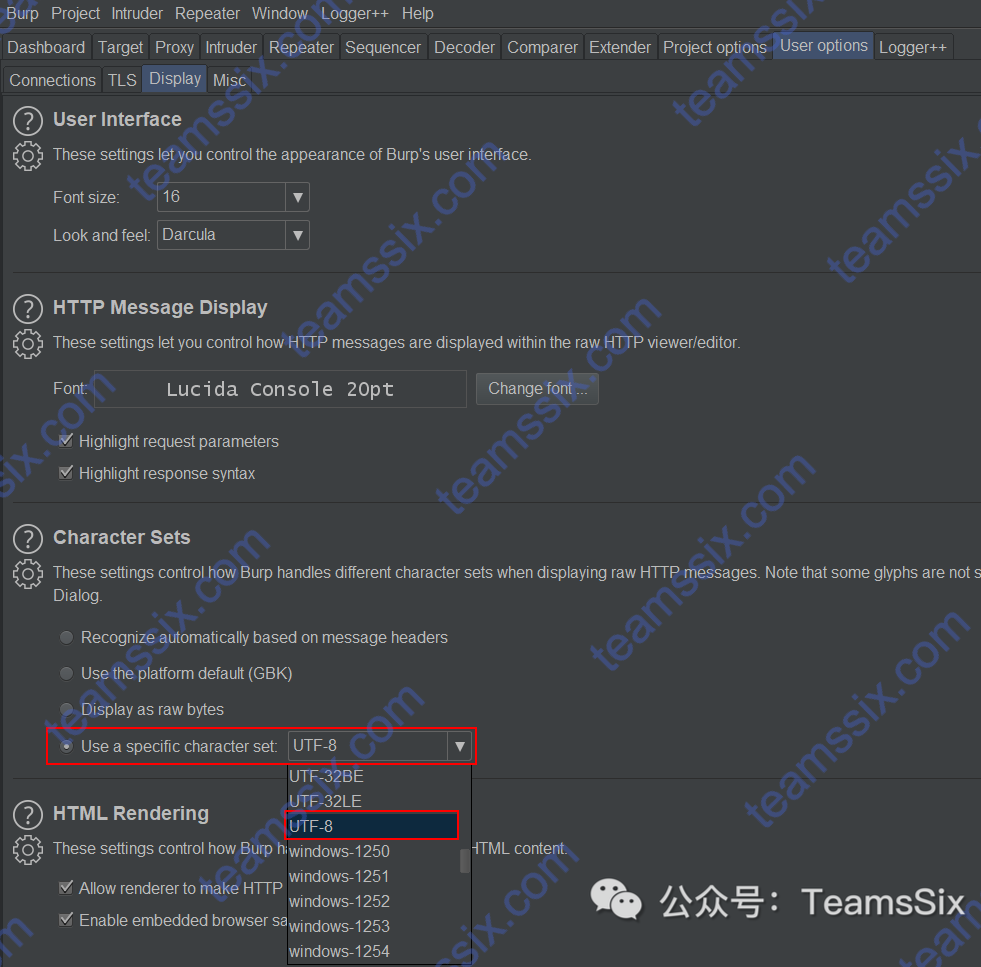

【经验总结】解决 BurpSuite Pro v2020.1 版本中文乱码问题

【经验总结】解决 BurpSuite Pro v2020.1 版本中文乱码问题

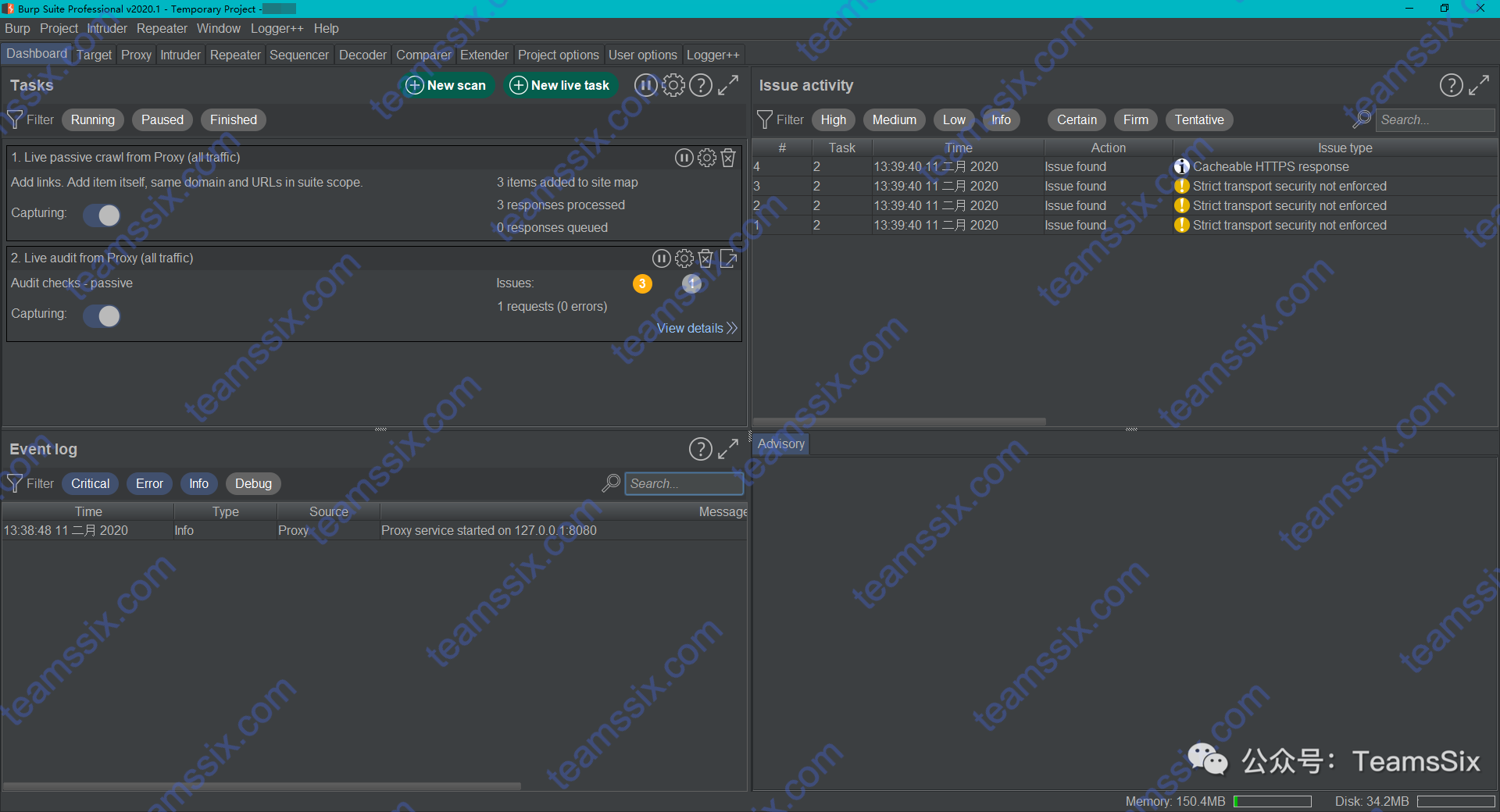

【工具分享】BurpSuite Pro v2020.1 无后门专业破解版

【工具分享】BurpSuite Pro v2020.1 无后门专业破解版

【摘要】漏洞组合拳之XSS+CSRF记录

【摘要】漏洞组合拳之XSS+CSRF记录

【经验总结】Python3 Requests 模块请求内容包含中文报错的解决办法

【经验总结】Python3 Requests 模块请求内容包含中文报错的解决办法

【经验总结】SQL注入Bypass安全狗360主机卫士

【经验总结】SQL注入Bypass安全狗360主机卫士

【Python Scrapy 爬虫框架】 6、继续爬虫、终止和重启任务

【Python Scrapy 爬虫框架】 6、继续爬虫、终止和重启任务

【Python Scrapy 爬虫框架】 5、利用 pipelines 和 settings 将爬取数据存储到 MongoDB

【Python Scrapy 爬虫框架】 5、利用 pipelines 和 settings 将爬取数据存储到 MongoDB

【Python Scrapy 爬虫框架】 4、数据项介绍和导出文件

【Python Scrapy 爬虫框架】 4、数据项介绍和导出文件

【Python Scrapy 爬虫框架】 3、利用 Scrapy 爬取博客文章详细信息

【Python Scrapy 爬虫框架】 3、利用 Scrapy 爬取博客文章详细信息

【Python Scrapy 爬虫框架】 2、利用 Scrapy 爬取我的博客文章标题链接

【Python Scrapy 爬虫框架】 2、利用 Scrapy 爬取我的博客文章标题链接

【Python Scrapy 爬虫框架】 1、简介与安装

【Python Scrapy 爬虫框架】 1、简介与安装

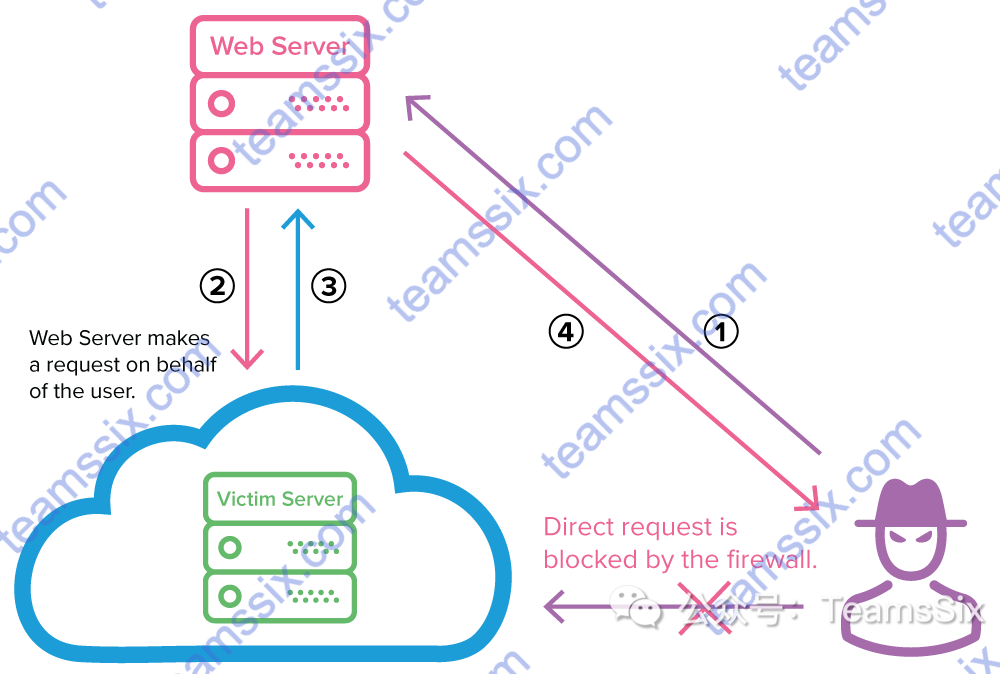

【漏洞笔记】浅谈SSRF原理及其利用

【漏洞笔记】浅谈SSRF原理及其利用

【Python 学习笔记】 异步IO (asyncio) 协程

【Python 学习笔记】 异步IO (asyncio) 协程

【Python 学习笔记】多进程爬虫

【Python 学习笔记】多进程爬虫